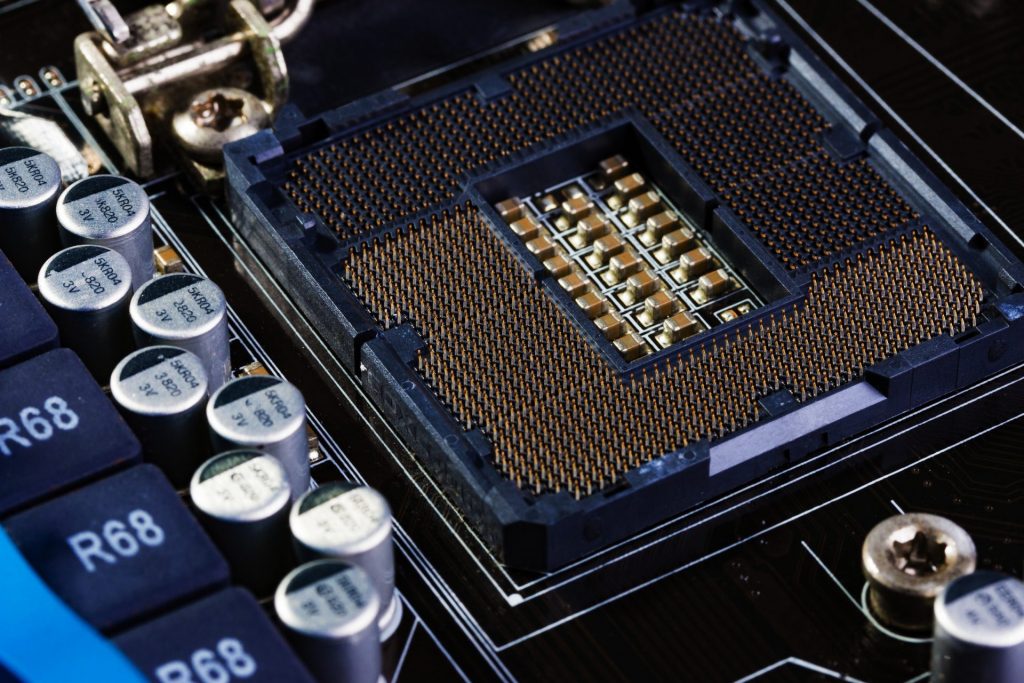

Sabemos que, infelizmente, nenhuma máquina é cem por cento eficiente no quesito calor. Sempre há uma dissipação que reduz sua eficiência. Nos Estados Unidos, estima-se que até dois terços da energia consumida seja desperdiçada na forma de calor. Pensando nisso, alguns engenheiros desenvolveram um chip que converte calor remanescente em energia utilizável.

Os exemplos mais comuns de dissipação de calor que nos cercam são vários: aparelhos celulares, computadores, geladeiras, motores de automóveis, etc. A possibilidade de usar esse calor gerado para transformá-lo em mais energia é incrível. Continue lendo este artigo do Engenharia 360 para saber mais!

Como funciona o chip que converte calor dissipado em energia?

O responsável pela pesquisa do chip é Mathieu Francoeur, professor associado de Engenharia Mecânica da Universidade de Utah. Ele criou uma forma de produzir mais energia a partir de calor dissipado usando um chip de silício.

Tal chip é um dispositivo que converte radiação térmica em energia. Antes, os pesquisadores já haviam descoberto que existe um limite teórico para quanta energia pode ser produzida por radiação térmica (calor). Porém, a equipe de Francoeur mostrou que eles são capazes de ir; além disso, se usarem um dispositivo com duas superfícies de silício muito próximas, em uma nanoescala.

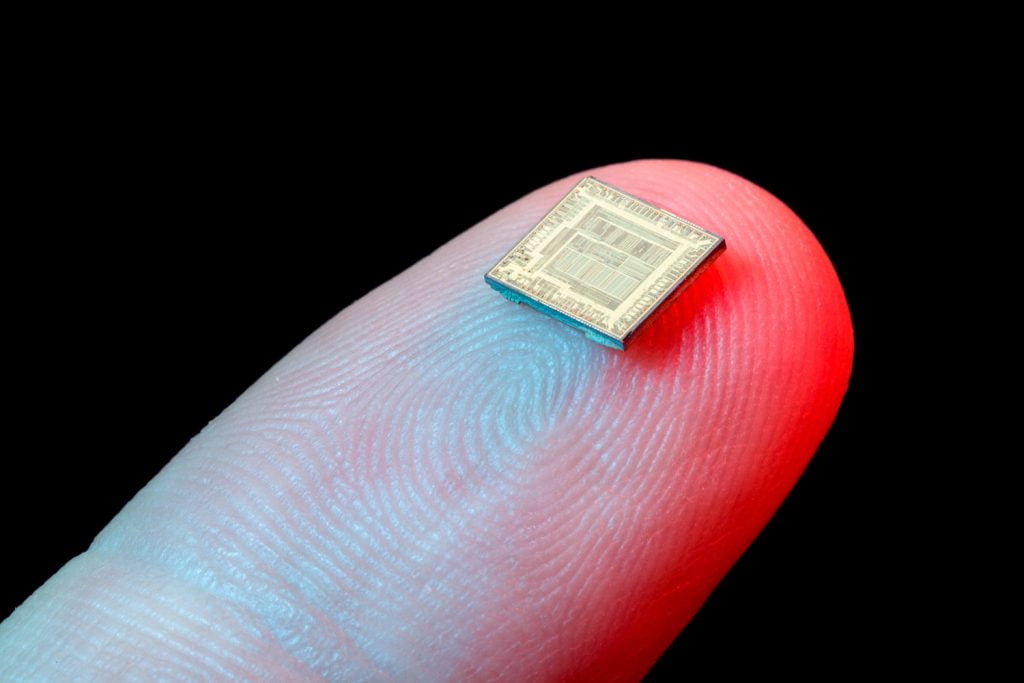

A saber, o chip possui aproximadamente 5 mm por 5 mm. Nele, as placas de silício são separadas por um espaço de 100 nanômetros de espessura (um milésimo de um fio de cabelo humano). Quanto mais próximas, mais eletricidade podem gerar.

Veja Também: Revolução dos chips de IA, a nova fronteira da tecnologia

Aplicações futuras e benefícios

A esperança é de que, no futuro, essa tecnologia possa ser usada não só para resfriar dispositivos portáteis (um grande problema atual que contribui para danos na bateria do aparelho) como também para canalizar esse calor para a maior duração da bateria. Por exemplo, um notebook com bateria que dura cerca de 6 horas poderia atingir 9 horas de duração.

Outro benefício é o fato de melhorar a vida útil de processadores de computador, reduzindo o desgaste. Consequentemente, o dispositivo contribui para maior sustentabilidade e o meio ambiente agradece.

Fontes: Phys.org.

Imagens: Todos os Créditos reservados aos respectivos proprietários (sem direitos autorais pretendidos). Caso eventualmente você se considere titular de direitos sobre algumas das imagens em questão, por favor entre em contato com contato@engenharia360.com para que possa ser atribuído o respectivo crédito ou providenciada a sua remoção, conforme o caso.

Comentários

Larissa Fereguetti

Cientista e Engenheira de Saúde Pública, com mestrado, também doutorado em Modelagem Matemática e Computacional; com conhecimento em Sistemas Complexos, Redes e Epidemiologia; fascinada por tecnologia.